Искусственный интеллект (ИИ) на основе языковых моделей за последние годы значительно продвинулся. К 2024 году несколько ведущих языковых моделей доминируют в различных приложениях, от автоматизации текста до помощи в научных исследованиях.

Рассмотрим топ-6 моделей, их характеристики, производительность, требования к аппаратному обеспечению и используемые методы оценки.

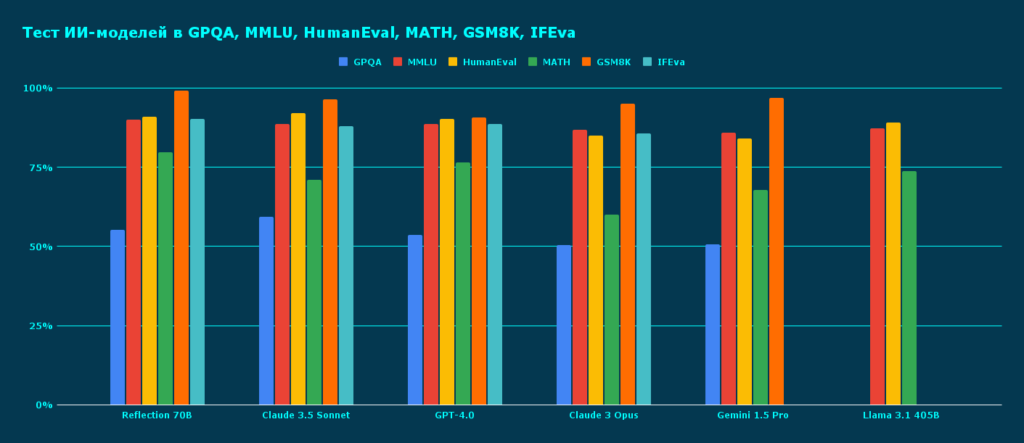

Рейтинг составили такие языковые модели, как Reflection 70B, Claude 3.5 Sonnet, GPT-4.0, Claude 3 Opus, Gemini 1.5 Pro, Llama 3.1 405B.

- Бенчмарки и принципы оценки

- Принципы оценки

- Отличия рекомендуемых GPU

- Сравнительная таблица показателей производительности ИИ-моделей

- Место №1. Reflection 70B

- Производительность

- Требования к GPU

- Место №2. Claude 3.5 Sonnet

- Производительность

- Требования к GPU

- Место №3. GPT-4.0

- Производительность

- Требования к GPU

- Место №4. Claude 3 Opus

- Производительность

- Требования к GPU

- Место №5. Gemini 1.5 Pro

- Производительность

- Требования к GPU

- Место №6. Llama 3.1 405B

- Производительность

- Требования к GPU

- Заключение

Бенчмарки и принципы оценки

Для оценки производительности языковых моделей используются различные бенчмарки:

Бенчмарк — это эталонный показатель, используемый для сравнения и анализа текущего состояния какой-либо системы.

GPQA (Grounded Principle Question Answering): оценивает способность модели отвечать на вопросы, основанные на принципах.

(Massive Multitask Language Understanding): тестирует понимание модели в различных областях знаний.

HumanEval: оценивает способность модели генерировать код.

MATH: тестирует математические способности модели.

GSM8K (Grade School Math 8K): оценивает способность модели решать математические задачи уровня начальной школы.

IFEval: оценивает способность модели к логическому рассуждению и выводу.

Принципы оценки

- 0-shot: модель дает ответ без предварительных примеров.

- Few-shot (например, 5-shot): модели предоставляется несколько примеров перед выполнением задачи.

- CoT (Chain-of-Thought): модель объясняет свой ход мыслей при решении задачи.

Отличия рекомендуемых GPU

Различные модели ИИ требуют разных GPU по нескольким причинам:

Объем памяти: Более крупные модели, такие как Reflection 70B и Llama 3.1 405B, требуют GPU с большим объемом памяти для хранения параметров модели.

Производительность: Модели с большим количеством параметров требуют более высокой вычислительной мощности для обработки данных.

Архитектура: Некоторые модели могут быть оптимизированы для определенных архитектур GPU.

Энергоэффективность: Для длительной работы с моделями важна энергоэффективность GPU.

- Поддержка специфических операций: Некоторые модели могут использовать специфические операции, которые лучше поддерживаются определенными GPU.

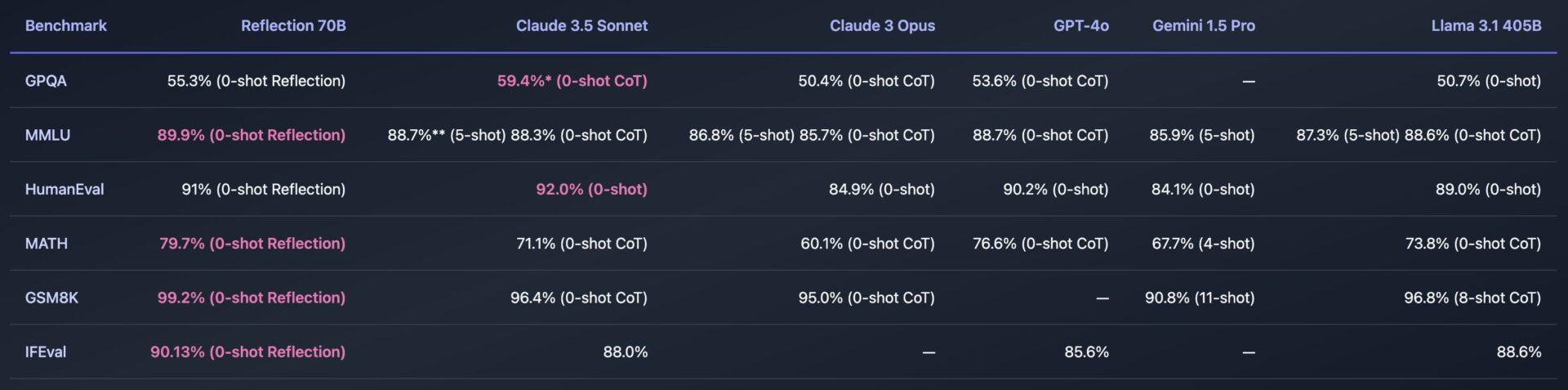

Сравнительная таблица показателей производительности ИИ-моделей

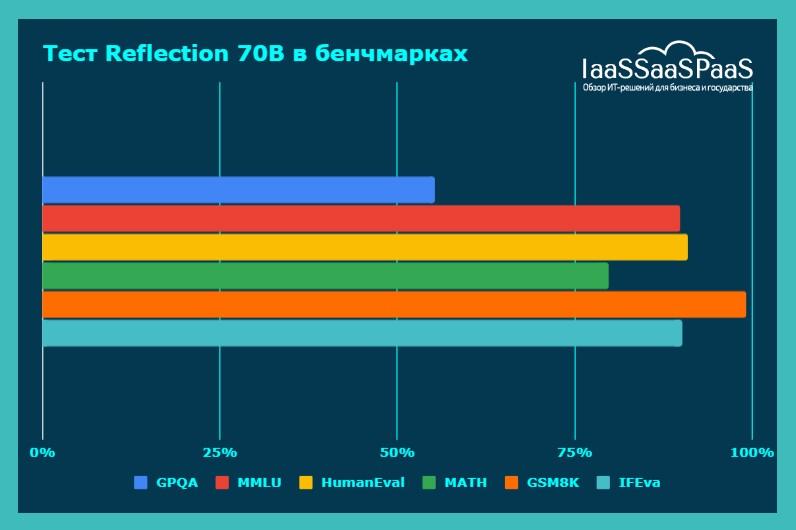

Место №1. Reflection 70B

Reflection 70B — новейшая языковая модель, разработанная на основе Llama 3.1 с использованием передовой технологии обучения Reflection-Tuning.

Reflection-Tuning — методика обучения, которая позволяет ИИ обнаруживать неточности в собственном рассуждении и исправлять их перед окончательным формированием ответа.

Эта модель способна самостоятельно выявлять и корректировать свои ошибки в процессе генерации текста, что делает её особенно точной и надёжной для сложных задач. В отличие от других моделей, она вносит правки на каждом этапе создания текста, что значительно повышает её эффективность в реальных приложениях.

Производительность модели на различных бенчмарках впечатляет. Например, она набирает 55,3% на GPQA в режиме 0-shot, а на MMLU достигает 89,9%, что значительно превышает показатели многих других моделей. В задачах, связанных с математическими вычислениями (MATH), её производительность составляет 79,7%, а в тестах по логическим рассуждениям (IFEval) — 90,13%. Эти результаты показывают, что Reflection 70B является одной из лучших моделей в своей категории на сегодняшний день.

Производительность

- GPQA: 55,3% (0-shot Reflection)

- MMLU: 89,9% (0-shot Reflection)

- HumanEval: 91% (0-shot Reflection)

- MATH: 79,7% (0-shot Reflection)

- GSM8K: 99,2% (0-shot Reflection)

- IFEval: 90,13% (0-shot Reflection)

Требования к GPU

Для запуска Reflection 70B требуется мощная видеокарта, такая как NVIDIA H100. Карта обладает 80 ГБ видеопамяти HBM2e и обеспечивает производительность до 312 TFLOPS для операций с тензорами.

Стоимость NVIDIA A100 на российском рынке составляет около 2,3 млн рублей (сентябрь, 2024).

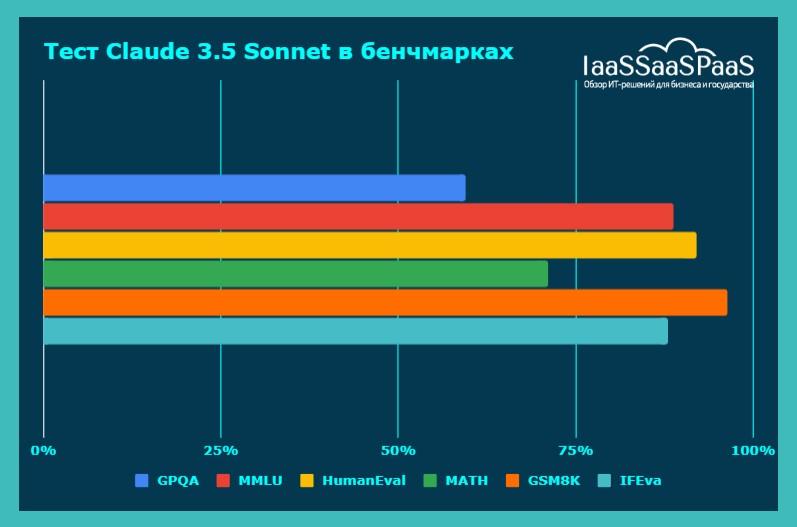

Место №2. Claude 3.5 Sonnet

Claude 3.5 Sonnet — это продвинутая версия языковой модели Claude, разработанная компанией Anthropic, которая уделяет большое внимание этическим аспектам разработки искусственного интеллекта. Модель была создана с целью минимизировать потенциальные риски при использовании ИИ в высокоответственных областях, таких как здравоохранение, юриспруденция и государственные проекты. Этичность работы модели является одним из её ключевых преимуществ.

Claude 3.5 Sonnet активно используется в задачах, требующих высокой точности и аккуратности обработки данных. Её внедрение в государственные структуры связано с необходимостью соблюдения этических стандартов при работе с конфиденциальной информацией и снижении рисков принятия неверных решений. Кроме того, модель хорошо себя зарекомендовала в коммерческих проектах, где её применяют для автоматизации взаимодействия с клиентами и анализа больших объёмов данных.

Производительность модели на бенчмарках отражает её адаптацию к широкому спектру задач. Например, на GPQA она показывает 59,4% в режиме 0-shot CoT, а на MMLU достигает 88,7% в режиме 5-shot. Её способность к генерации кода также высоко оценена: в тесте HumanEval она набрала 92,0%. Эти показатели подтверждают, что модель справляется как с текстовыми, так и с кодовыми задачами.

Производительность

- GPQA: 59,4% (0-shot CoT)

- MMLU: 88,7% (5-shot), 88.3% (0-shot CoT)

- HumanEval: 92% (0-shot)

- MATH: 71,1% (0-shot CoT)

- GSM8K: 96,4% (0-shot CoT)

- IFEval: 88%

Требования к GPU

Для Claude 3.5 Sonnet рекомендуется использовать NVIDIA Tesla V100. Эта карта имеет 32 ГБ памяти HBM2 и обеспечивает производительность до 125 TFLOPS для операций с тензорами.

Стоимость NVIDIA Tesla V100 на российском рынке составляет около 800 тысяч рублей (сентябрь, 2024)

Место №3. GPT-4.0

GPT-4.0 от OpenAI является продолжением успешной линейки GPT-моделей и остаётся эталоном в области генеративных языковых моделей. Её разработка направлена на улучшение понимания контекста и расширение способностей к многоязычной обработке данных. GPT-4.0 продолжает быть одной из самых востребованных моделей для задач генерации текста, включая статьи, рассказы, диалоги и более сложные сценарии, требующие анализа и синтеза информации.

Модель отличается гибкостью в применении: её используют в чат-ботах, системах автоматизации обработки запросов, а также в программах для генерации текста и анализа больших объёмов данных. Важным аспектом GPT-4.0 является её способность адаптироваться к различным видам задач — от базовых текстовых операций до сложных аналитических и креативных решений, таких как написание художественных текстов или программного кода.

Показатели GPT-4.0 на бенчмарках продолжают впечатлять: модель набирает 53,6% на GPQA в режиме 0-shot CoT и достигает 88,7% на MMLU, что говорит о её сильных аналитических способностях. В тестах по генерации кода (HumanEval) она показывает результат 90,2%, что делает её одним из лидеров в своей области.

Производительность

- GPQA: 53,6% (0-shot CoT)

- MMLU: 88,7% (0-shot CoT)

- HumanEval: 90,2% (0-shot)

- MATH: 76,6% (0-shot CoT)

- GSM8K: 90,8% (11-shot)

- IFEval: 88,6%

Требования к GPU

Для GPT-4.0 рекомендуется использовать NVIDIA A100 или более новые модели.

Стоимость NVIDIA A100 на российском рынке составляет около 2,3 млн рублей (сентябрь, 2024).

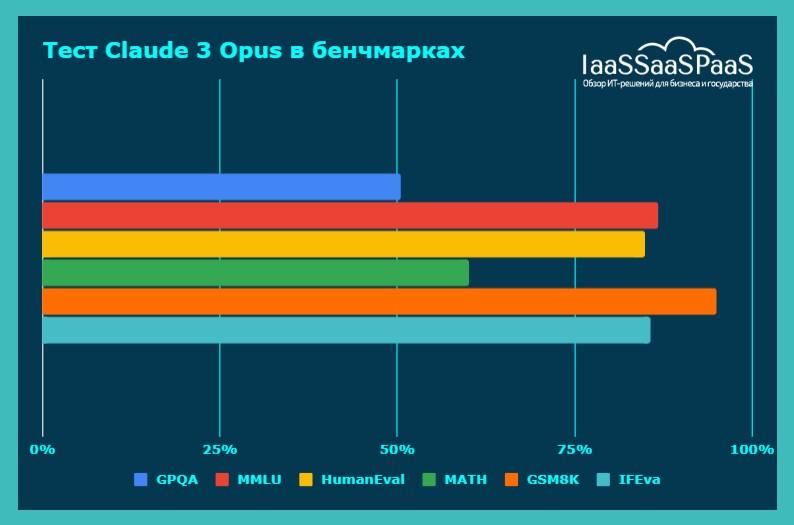

Место №4. Claude 3 Opus

Claude 3 Opus от компании Anthropic представляет собой новейшую версию их передовой языковой модели. Она демонстрирует впечатляющие результаты на ключевых бенчмарках, таких как GPQA, MMLU и HumanEval, подтверждая свои мощные аналитические способности и умение работать с кодом.

На задаче GPQA в режиме 0-shot CoT Claude 3 Opus набирает 50,4%, что свидетельствует о её глубоком понимании контекста и способности делать логические выводы. На MMLU она показывает результат 86,8% в режиме 5-shot и 85,7% в режиме 0-shot CoT, демонстрируя выдающиеся возможности в области многозадачного обучения.

Особенно выделяются достижения модели в генерации кода — на наборе данных HumanEval она достигает впечатляющих 84,9% в режиме 0-shot. Это делает Claude 3 Opus одним из лидеров в области генеративного программирования.

Производительность

- GPQA: 50,4% (0-shot CoT)

- MMLU: 86,8% (5-shot), 85.7% (0-shot CoT)

- HumanEval: 84,9% (0-shot)

- MATH: 60,1% (0-shot CoT)

- GSM8K: 95,0% (0-shot CoT)

- IFEval: 85,6%

Требования к GPU

Для Claude 3 Opus также рекомендуется использовать NVIDIA Tesla V100 или более мощные карты.

Стоимость NVIDIA Tesla V100 на российском рынке составляет около 800 тысяч рублей (сентябрь, 2024)

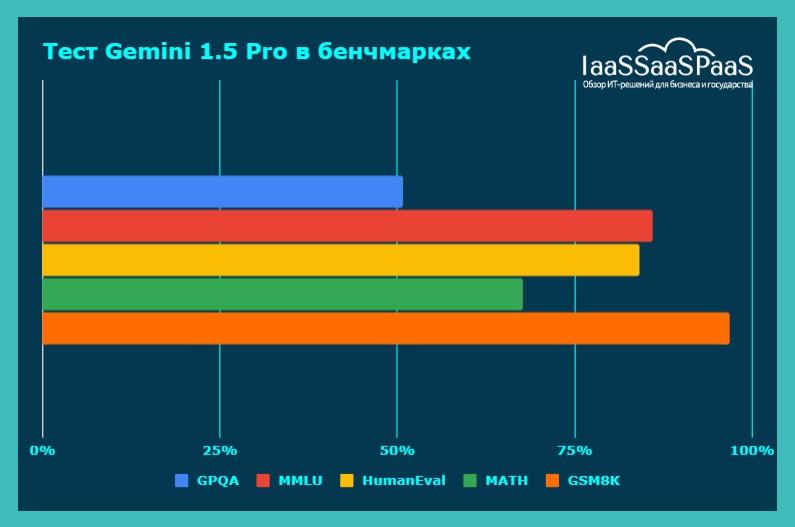

Место №5. Gemini 1.5 Pro

Gemini 1.5 Pro от DeepMind демонстрирует стабильно высокие результаты на различных бенчмарках, подтверждая свой статус одной из ведущих языковых моделей нового поколения.

На задаче GPQA в режиме 0-shot она набирает 50,7%, что сопоставимо с лидерами в этой области. В тесте MMLU Gemini 1.5 Pro показывает результат 85,9% в режиме 5-shot, подтверждая свои мощные многозадачные способности.

Модель также отлично справляется с генерацией кода, достигая 84,1% на HumanEval в режиме 0-shot. На математических тестах MATH ее результат составляет 67,7% в режиме 4-shot.

Что касается задачи GSM8K, то здесь Gemini 1.5 Pro демонстрирует выдающийся результат 96,8% в режиме 8-shot CoT, подтверждая свои возможности в области контекстуального обобщения.

Производительность

- GPQA: 50,7% (0-shot)

- MMLU: 85,9% (5-shot)

- HumanEval: 84,1% (0-shot)

- MATH: 67,7% (4-shot)

- GSM8K: 96,8% (8-shot CoT)

- IFEval: данные отсутствуют

Требования к GPU

Для Gemini 1.5 Pro рекомендуется использовать NVIDIA A100.

Стоимость NVIDIA A100 на российском рынке составляет около 2,3 млн рублей (сентябрь, 2024).

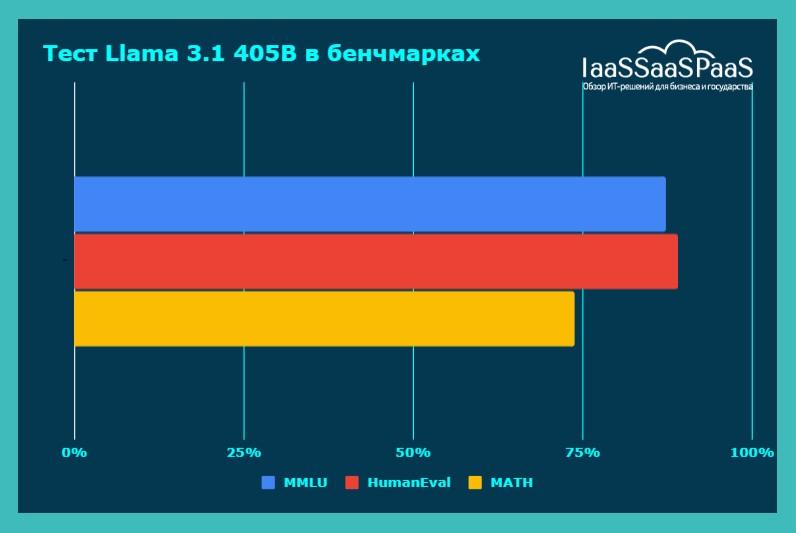

Место №6. Llama 3.1 405B

Llama 3.1 405B от Meta AI* представляет собой масштабную языковую модель, обладающую впечатляющими возможностями в различных областях. Несмотря на отсутствие данных по некоторым бенчмаркам, ее результаты на тестах MMLU, HumanEval и MATH говорят сами за себя.

На MMLU Llama 3.1 405B демонстрирует результат 87,3% в режиме 5-shot и 88,6% в режиме 0-shot CoT, что является одним из лучших показателей в этой области. В генерации кода на HumanEval модель набирает 89,0% в режиме 0-shot, опережая многие другие решения.

Особенно впечатляющими являются достижения Llama 3.1 405B на математических тестах MATH, где она показывает результат 73,8% в режиме 0-shot CoT. Это свидетельствует о ее выдающихся аналитических способностях и умении работать с числовыми данными

* — Деятельность Meta Platforms Inc. и принадлежащей ей Meta AI запрещена на территории РФ.

Производительность

- GPQA: данные отсутствуют

- MMLU: 87,3% (5-shot), 88.6% (0-shot CoT)

- HumanEval: 89% (0-shot)

- MATH: 73,8% (0-shot CoT)

- GSM8K: данные отсутствуют

- IFEval: данные отсутствуют

Требования к GPU

Для Llama 3.1 405B требуются самые мощные GPU. Рекомендуется использование NVIDIA H100, обладающей впечатляющими характеристиками для обработки больших объёмов данных.

Стоимость NVIDIA H100 на российском рынке составляет около 3,9 млн рублей (сентябрь, 2024).

Заключение

Мир ИИ-моделей продолжает стремительно развиваться. Каждая модель демонстрирует впечатляющие результаты. Однако стоит отметить, что для работы с такими продвинутыми моделями требуется дорогостоящее оборудование, что может ограничивать их широкое применение в бизнесе.

Несмотря на технологический прогресс, многие компании все еще находятся на начальных этапах внедрения ИИ в свои бизнес-процессы. Потенциал этих технологий огромен, но требуется время для разработки эффективных стратегий их применения в различных отраслях.